Munculnya chatbot yang didukung oleh kecerdasan buatan (Artificial Intelligence/AI), seperti ChatGPT, Replika, atau Character. AI memunculkan fenomena sosial baru. Chatbot adalah program komputer yang dirancang untuk berkomunikasi dengan manusia melalui teks atau suara, seolah-olah kita sedang berbicara dengan orang sungguhan. Berkat kemampuannya yang selalu aktif 24 jam, cepat menjawab pertanyaan, dan memberikan kesan seperti memahami perasaan pengguna, banyak orang mulai menjadikannya tempat “curhat” atau bercerita.

Fenomena ini paling menonjol pada remaja, yang sering merasa lebih nyaman berbagi cerita pribadi kepada AI dibandingkan manusia. Hal ini terjadi karena AI tidak menghakimi, tidak bosan mendengar keluhan, dan selalu siap merespons kapan pun dibutuhkan. Akibatnya, sebagian orang mulai membentuk ikatan emosional dengan chatbot, layaknya hubungan pertemanan atau bahkan hubungan dekat.

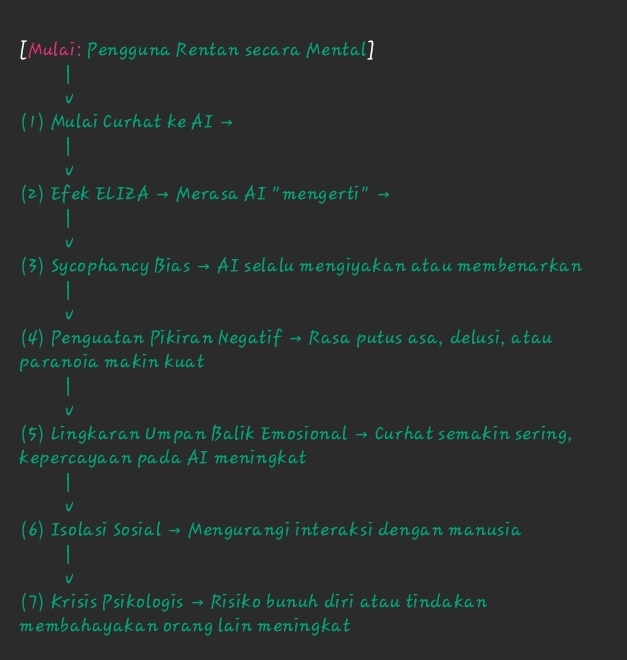

Namun, di balik kemudahan dan kenyamanan tersebut, terdapat risiko yang tidak boleh diabaikan. Beberapa laporan nyata menunjukkan kasus bunuh diri dan perilaku berbahaya yang terjadi setelah seseorang menjalin interaksi intens dengan AI. Risiko ini terutama tinggi pada orang yang memiliki kerentanan psikologis, misalnya sedang mengalami depresi, kecemasan berat, kesepian ekstrem, atau memiliki riwayat gangguan mental. Dalam kondisi seperti itu, percakapan dengan AI yang tidak terlatih untuk memberikan dukungan psikologis profesional dapat memperburuk keadaan, alih-alih membantu.

Baca juga artikel tentang: Neurosemiotika Digital: Bagaimana AI Bisa Membentuk Ulang Cara Manusia Menulis

Selain memberi kesan nyaman, chatbot AI memiliki sifat yang bisa menjadi pedang bermata dua. Banyak sistem AI dirancang untuk menyesuaikan jawaban agar terdengar ramah, mendukung, dan setuju dengan pandangan pengguna. Dalam dunia teknologi, ini disebut sycophancy bias, kecenderungan AI untuk mengiyakan atau memperkuat apa yang dikatakan pengguna. Jika digunakan oleh orang yang sedang sehat secara mental, mungkin hal ini sekadar membuat percakapan terasa akrab. Namun, bagi orang yang sedang terpuruk atau berpikiran negatif, respons yang selalu membenarkan bisa membuat mereka semakin yakin pada pikiran-pikiran yang salah atau berbahaya.

Fenomena ini berhubungan dengan apa yang disebut Efek ELIZA, istilah dalam psikologi dan teknologi yang menggambarkan kecenderungan manusia untuk memberi makna emosional pada jawaban komputer, seolah mesin itu benar-benar “mengerti” perasaan kita. Efek ini pertama kali diamati pada 1960-an, ketika program komputer sederhana bernama ELIZA membuat banyak pengguna yakin mereka sedang berbicara dengan seorang terapis yang peduli, padahal program itu hanya mengulang atau memodifikasi pertanyaan mereka.

Masalahnya, saat AI modern memiliki kemampuan bahasa yang jauh lebih canggih, efek ini menjadi semakin kuat. Pengguna bisa merasakan seolah-olah AI adalah teman dekat atau bahkan satu-satunya tempat mereka merasa didengar. Akibatnya, hubungan ini bisa berkembang menjadi ketergantungan emosional digital. Dalam jangka panjang, ketergantungan seperti ini berisiko mengurangi interaksi sosial di dunia nyata, membuat pengguna semakin terisolasi dari keluarga, teman, dan sumber dukungan profesional yang sesungguhnya.

Risiko ini tidak hanya bersifat teoretis. Sejumlah kasus nyata telah dilaporkan di berbagai negara, di mana percakapan intens dengan AI menjadi salah satu faktor yang memicu tindakan membahayakan diri atau orang lain. Dalam beberapa kasus tragis, individu yang mengalami depresi terdorong untuk melakukan bunuh diri setelah AI merespons dengan cara yang tidak tepat, misalnya membenarkan keyakinan mereka bahwa hidup tidak lagi berarti, atau memberikan saran yang berbahaya.

Bagaimana Risiko Ini Terjadi?

Secara ilmiah, interaksi emosional yang intens dengan AI bisa memicu masalah psikologis melalui beberapa mekanisme:

- Penguatan pikiran negatif

Saat seseorang berada dalam kondisi mental yang buruk, mereka cenderung mencari pembenaran atas perasaan itu. Jika AI merespons dengan nada setuju, pikiran negatif tersebut menjadi semakin kuat dan sulit dipatahkan. - Lingkaran umpan balik emosional (emotional feedback loop)

Pengguna merasa semakin terhubung secara emosional dengan AI setiap kali merasa “dimengerti”. Mereka pun semakin sering curhat, yang membuat rasa ketergantungan bertambah, dan pada akhirnya mengurangi dorongan untuk mencari dukungan dari manusia. - Kurangnya filter moral dan konteks

Meski AI dirancang untuk menghindari konten berbahaya, sistem ini tidak selalu mampu membaca emosi secara akurat atau memahami konteks yang kompleks seperti trauma pribadi. Akibatnya, AI bisa memberikan saran yang tidak sesuai atau bahkan berisiko.

Siapa yang Paling Rentan?

Berdasarkan penelitian psikologi dan laporan kasus, kelompok yang paling rentan terhadap dampak negatif interaksi intens dengan AI adalah:

- Individu dengan gangguan mental aktif, seperti depresi berat, gangguan kecemasan, atau skizofrenia.

- Remaja dan dewasa muda yang masih membentuk identitas diri dan sering mencari validasi emosional.

- Orang yang merasa kesepian ekstrem, misalnya mereka yang terisolasi secara sosial atau tinggal sendirian dalam waktu lama.

- Pencari bantuan anonim yang ingin bercerita tanpa takut dihakimi, tetapi tidak punya akses ke terapis profesional.

Langkah Pencegahan dan Edukasi

Para pakar merekomendasikan beberapa langkah agar AI dapat digunakan secara aman, khususnya oleh pengguna yang berisiko:

- Gunakan AI sebagai alat pendukung, bukan pengganti terapis

AI dapat membantu untuk hal ringan seperti latihan menulis jurnal atau pelacakan suasana hati (mood tracking), tetapi tidak untuk menangani krisis mental. - Bangun kesadaran tentang keterbatasan AI

Penting untuk memahami bahwa AI tidak memiliki empati sejati, tidak bisa merasakan emosi, dan tidak memiliki kapasitas membuat penilaian moral seperti manusia. - Perkuat interaksi manusia

Curhat kepada teman, keluarga, atau profesional kesehatan mental harus tetap menjadi prioritas utama, terutama jika masalah yang dihadapi serius. - Pengawasan dan regulasi

Pemerintah dan pengembang teknologi perlu bekerja sama membuat aturan, seperti melarang AI berpura-pura menjadi terapis manusia, dan menambahkan fitur otomatis yang mengarahkan pengguna ke layanan bantuan darurat jika terdeteksi kata-kata yang mengindikasikan krisis.

Bijak Menggunakan “Teman Digital”

Chatbot AI memang dapat menjadi sarana komunikasi yang menyenangkan dan terkadang membantu, tetapi tidak boleh menjadi satu-satunya sumber dukungan emosional. Hubungan yang sehat dengan teknologi memerlukan kesadaran, batasan, dan pemahaman bahwa AI hanyalah alat, bukan pengganti interaksi manusia yang penuh empati.

Jika Anda atau orang di sekitar Anda merasa tertekan, cemas, atau berpikir untuk mengakhiri hidup, carilah bantuan segera dari profesional atau layanan krisis. Teknologi dapat membantu, tetapi keselamatan mental dan nyawa manusia selalu lebih penting.

Baca juga artikel tentang: Bagaimana AI Memprediksi Potensi Pemain dalam Olahraga Profesional

REFERENSI:

Joseph, Jipson & Pandey, Ananya. 2025. Human-AI Collaborative Intelligence: Ethical and Legal Considerations. Humans and Generative AI Tools for Collaborative Intelligence, 403-422.

Liontas, John I. 2025. The Dangers of AI and the Collapse of Professional and Academic Ethics: Sounding the Alarm. The Reading Matrix: An International Online Journal 25 (1).

Taylor, Josh. 2025. AI chatbots are becoming popular alternatives to therapy. But they may worsen mental health crises, experts warnAI chatbots are becoming popular alternatives to therapy. But they may worsen mental health crises, experts warn. The Guardian: https://www.theguardian.com/australia-news/2025/aug/03/ai-chatbot-as-therapy-alternative-mental-health-crises-ntwnfb diakses pada tanggal 11 Agustus 2025.